Innovation, Le projet cartographique, Les Carnet Cartographiques

Le 5e et dernier chapitre des Carnets Cartographiques

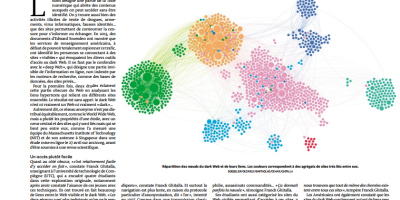

Les Carnet Cartographiques, les Chroniques du Web

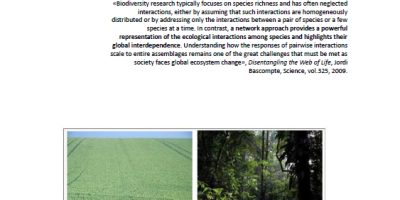

Cartographier la science, chapitre 4 des Carnets Cartographiques

Les Carnet Cartographiques, livre

Chapitre 3 des Carnets, la cartographie d’information

Les Carnets Cartographiques, les Chroniques du Web, livre, Uncategorized

Révélations, le second chapitre des Carnets Cartographiques

Les Carnets Cartographiques, les Chroniques du Web

Les Carnet Cartographiques

Le chapitre 10 des Chroniques

Le projet cartographique, les Chroniques du Web, livre

Le chapitre 9 des Chroniques, L’Information en n Dimensions

Le temps dans les cartes, les Chroniques du Web

Broadcast ou viralité? Le chapitre 8 des Chroniques

Innovation, Le projet cartographique, news

Vous devez être connecté pour poster un commentaire.